排序

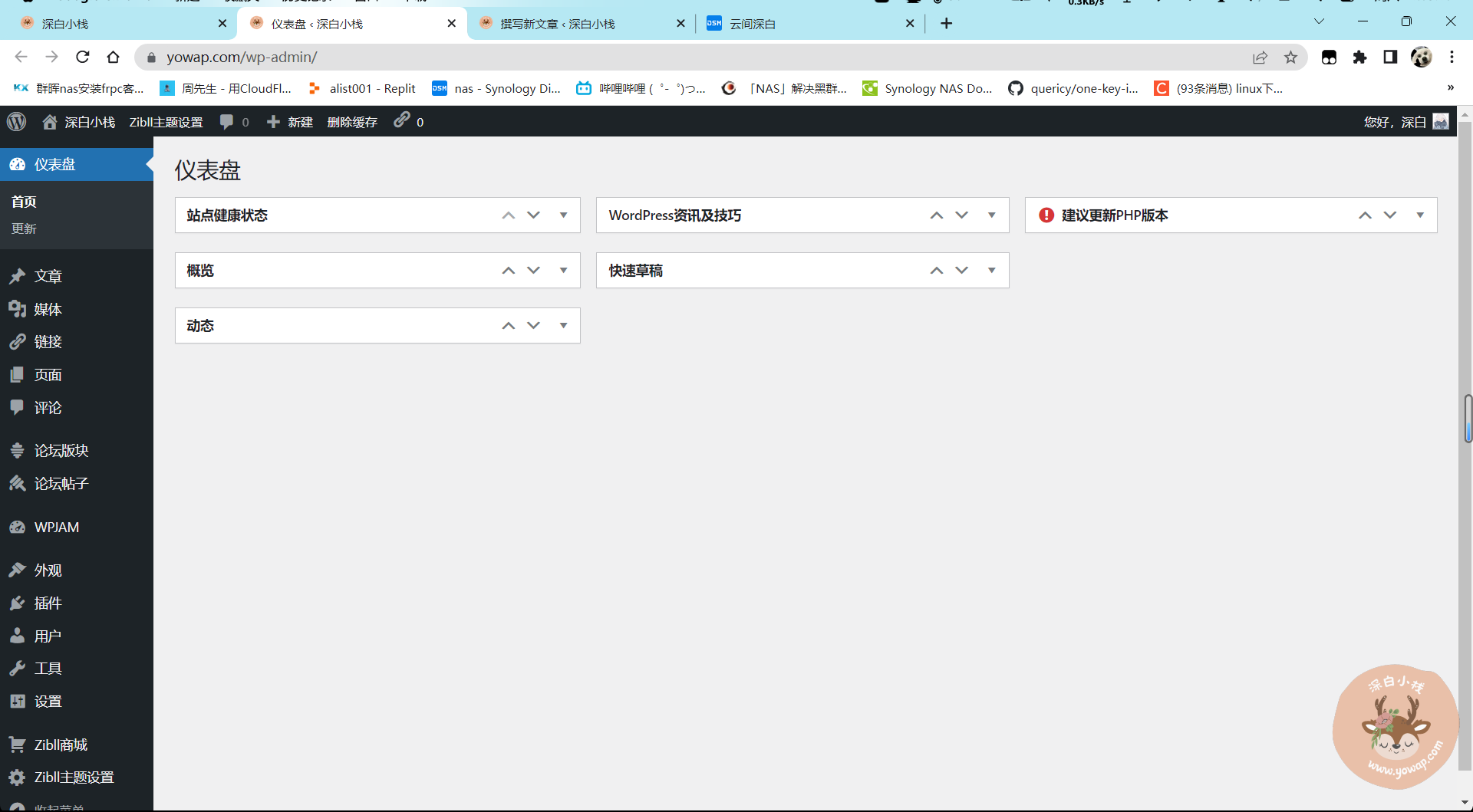

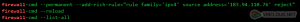

网站域名解红白拦截方法! 稳定解除!

还在为自己的网站在腾讯被显示非官方或者直接提示危险网站而导致拦截访问而发愁吗?还在为客户在打不开网站而只能复制到浏览器打开而烦恼吗?还在为用了防洪短链是不是访问失败吗?接下来小编给...

分享一个防止恶意刷关键词的代码

近期我发现我的网站有些人利用在网址后面加/s?wd=2ec500404165b5c71df9ada69d16f790代码来起到标识浏览器搜索时搜索的关键词,也就是可以给你的网站标识一些非法(关键词)违禁词,那么我们该如...

利用JS加密51统计/百度统计屏蔽垃圾广告词

上次利用代码来跳转别人访问的链接好像并没有啥用,仔细研究了一下,它们是通过咱们51统计、百度统计生成的id动态掩码来达到打广告的,所以这次咱们直接采用手动安装的方式去进行添加统计代码。...

初次建站时,站长在Ngink和Apache环境两者之间应该怎么选择?

Nginx和Apache是两款流行的Web服务器软件。在选择使用哪一个服务器软件时,需要考虑多种因素,包括应用程序类型、预期用户量、性能需求、配置和管理等。Apache是一个成熟的、稳定的、功能丰富的...

小白建站我为什么更推荐使用WordPress而不是typecho?

前言很多人在选择博客站时总是纠结使用WordPress还是typecho,亦或是像emlog,hexo,zblog等等,大多数大佬都是推荐typecho,一致意见是wp博客臃肿,那么,wp占地大吗?对的。但我还是推荐使用w...

网站SEO教程:robots.txt与SiteMap.xml的作用

robots.txt 文件规定了搜索引擎抓取工具允许/禁止请求抓取网站上的哪些网页或文件。SiteMap(站点地图)是一种文件,可以在其中提供与网站中的网页、视频或其他文件有关的信息,还可以说明这些...

网站怎么屏蔽禁止垃圾蜘蛛爬虫,节省网站资源消耗的优化教程

互联网上有很多的网络爬虫机器人,它们带着各自的任务到处爬行,但这些爬虫机器人有些是有用的,例如Baiduspider、Googlebot、bingbot等。但还有很多垃圾爬虫,对网站没有任何益处,还耗费资源...

网站提升SEO编辑robots.txt的正确用法

robots.txt(统一小写)是一种存放于网站根目录下的ASCII编码的文本文件,它通常告诉网络搜索引擎的漫游器(又称网络蜘蛛),此网站中的哪些内容是不应被搜索引擎的漫游器获取的,哪些是可以被...

WordPress网站的Robots文件应该怎么写呢

在建站基础教程中,我们介绍了什么是Robots文件以及它的作用是什么。(感兴趣,可以看下什么是robots协议)。在我们做网站优化过程中,Robots文件是比较重要的文件。对于WordPress建网站,应该...

nginx如何设置屏蔽指定来源网站访问本站的三个方法

前言:我们站长日常优化网站中,避免不了有恶意来源网站对我们的站点进行黑客行为扫站,或者别的采集大站对自己本站的文章进行偷偷采集,那要怎么避免这些行为呢?三个简单的nginx设置方法教你...

纯代码实现自动生成sitemap.xml网站地图-免插件

前言:Sitemap.xml 的重要性无须多讲了,就算是小站,但站点地图必不可少的;一方面方便搜索引擎来抓取,一方面也让自己了解相应的站点情况,一图在站,收录在手。使用教程:第一步:创建sitemap...

个人博客网站在备案期间怎么关闭首页无法访问,文章及其他页面正常访问

今天简单说一下域名备案期间怎么做到不关闭网站又不影响备案审核这可能就是要求首页不能访问,但是不影响其他页面和爬虫的一种操作手段,网上也有很多教程,可以直接使用,代码如下:JS代码:首...